Meta AI推出的Llama 2系列模型,参数量从7亿(7B)到70亿(70B)不等,这些模型在自然语言处理任务中展现出了卓越的性能。然而,随着模型规模的增加,对显存的需求也随之增长。本文将探讨运行Llama 2系列大模型所需的显存配置要求。

Llama 2系列模型是在Llama 1的基础上进行改进和扩展的,它们在预训练过程中使用了更多的数据和更长的上下文长度,以及引入了新的模型架构,如Group Query Attention(GQA)和Rotary Embeddings(RoPE),以提高模型的性能和效率。

显存需求分析

显存是运行大型模型的关键硬件资源,特别是在进行模型推理和训练时。Llama 2系列模型的显存需求取决于多个因素,包括模型的参数量、运行的精度(如全精度float32、半精度float16、8位或4位精度)以及其他运行时的内存需求。

全精度(float32)需求

半精度(float16)需求

7B模型:大约需要14GB的显存。

13B模型:显存需求降低到约26GB。

70B模型:显存需求为约140GB。

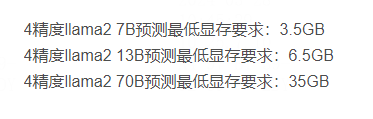

更低精度需求

显卡性能要求

除了显存大小,显卡的其他性能参数,如核心数、内存带宽和计算能力,也会影响模型的运行效率。高性能的显卡可以提供更快的数据处理速度和更高的并行计算能力,从而缩短模型推理和训练的时间。

推荐显卡配置

NVIDIA A100:拥有80GB的显存,适合运行大规模的LLMs,如Llama 2 70B模型。

RTX 3090:提供24GB的显存,适合运行中等规模的模型,如Llama 2 13B模型。

RTX 3080:拥有10GB显存,可以在半精度或更低精度下运行较小的模型,如Llama 2 7B模型。

优化技术

为了在有限的硬件资源上运行大型模型,可以采用多种优化技术,如模型量化、模型剪枝、混合精度训练等。这些技术可以显著减少模型的显存占用,同时尽量保持模型性能。

结论

Llama 2系列大模型对显卡配置有较高的要求,尤其是在全精度下。为了有效地部署和运行此类大型模型,需要选择具有足够显存和高性能的显卡。同时,通过采用优化技术,可以在资源有限的情况下实现模型的高效运行。随着硬件技术的不断进步,未来可能会有更多经济高效的解决方案来满足大型模型的运行需求。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

相关标签: