从NVIDIA H100到即将发布的B200 "Blackwell" 加速器,AI硬件正在迅速进化,以支持更大、更复杂的AI模型。这些进步在提高处理能力和效率方面发挥了重要作用,但同时也引发了关于本地化部署成本变化的讨论。考虑到B200的技术规格和预期的性能提升,我们可以探讨这种进步是否会导致大模型本地化部署成本的降低。

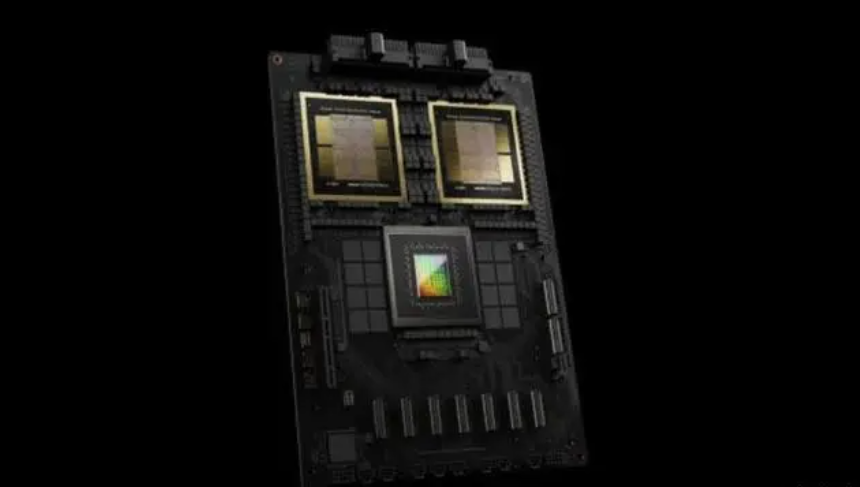

NVIDIA的H100是目前顶尖的AI加速器之一,以其高达700W的功耗和强大的计算能力为特点,相比之下,B200预计功耗将达到1000W,这标志着显著的性能提升和能耗增加,B200的设计旨在支持下一代大模型,预计将在处理速度、内存容量和能效方面提供显著改进。

评估本地化部署成本时,需要考虑几个关键因素:

硬件采购成本:更强大的GPU通常伴随着更高的采购价格。尽管NVIDIA尚未公布B200的定价,但其前沿技术和提升的性能指标意味着其市场价格可能会高于H100。

运行成本:功耗的增加直接影响能源消耗。B200的1000W功耗预示着较高的电力需求,这将增加长期运营成本。

冷却系统:如此高的功耗要求更高效的冷却解决方案,可能需要额外的投资来维持合适的操作温度,进一步增加部署成本。

性能提升:虽然B200的采购和运营成本可能高于H100,但其显著提升的处理能力和效率可能意味着更低的总拥有成本(TCO)。对于需要处理大量数据或复杂模型的场景,B200的高性能可能允许使用更少的硬件单位来完成相同的任务,从而在一定程度上抵消高成本。

能源效率:尽管B200的绝对功耗较高,但其每瓦特的性能提升可能更高。这种效率的增加有可能降低每次计算的能源成本,尤其是在高利用率下。

尽管B200 "Blackwell" 加速器带来了前所未有的计算能力和性能提升,但从目前可获得的信息来看,大模型本地化部署的总体成本不太可能降低。采购成本、能源消耗和冷却需求的增加可能会提高初期投资和长期运营成本。然而,对于特定的应用场景,B200带来的性能和效率提升可能会带来更高的成本效益,特别是当性能需求无法通过现有技术满足时。因此,对于评估是否采用B200,关键在于综合考虑性能需求、成本限制和长期效益。

相关标签: